Morgen will Apple anscheinend eine „iWatch“ vorstellen. Was man bis jetzt gesehen hat, überzeugt mich nicht und da ich schon lange in meiner Phantasie mit ein paar Konzepten spiele, habe ich diese kurzer Hand auf eine SmartWatch im Jahr 2034 adaptiert.

Man braucht keine sperrigen Computer mehr, stattdessen genügt ein hauchdünnes Armband. Da man in Zukunft sämtliche Elemente wie Chips, Sensoren, Leiterbahnen, Display und Solarzellen einfach auf ein Trägermaterial wie eine Folie, Stoff oder Papier etc. drucken kann (Quelle), ist es zu jener Zeit kein Problem, äußerst leistungsfähige „Hardware“ für alle möglichen Einsatzgebiete zu erstellen. Der Körper dient sowohl als Speichermedium (Festplatte, Cloud) wie als Leiterbahn und zusätzliche Energiequelle. Die körpereigenen sensorischen Fähigkeiten können vom Armband bei Wunsch abgefragt und bearbeitet werden. Berühre ich zum Beispiel eine Tasse sehe ich auf dem Display, wie heiß mein Kaffee ist.

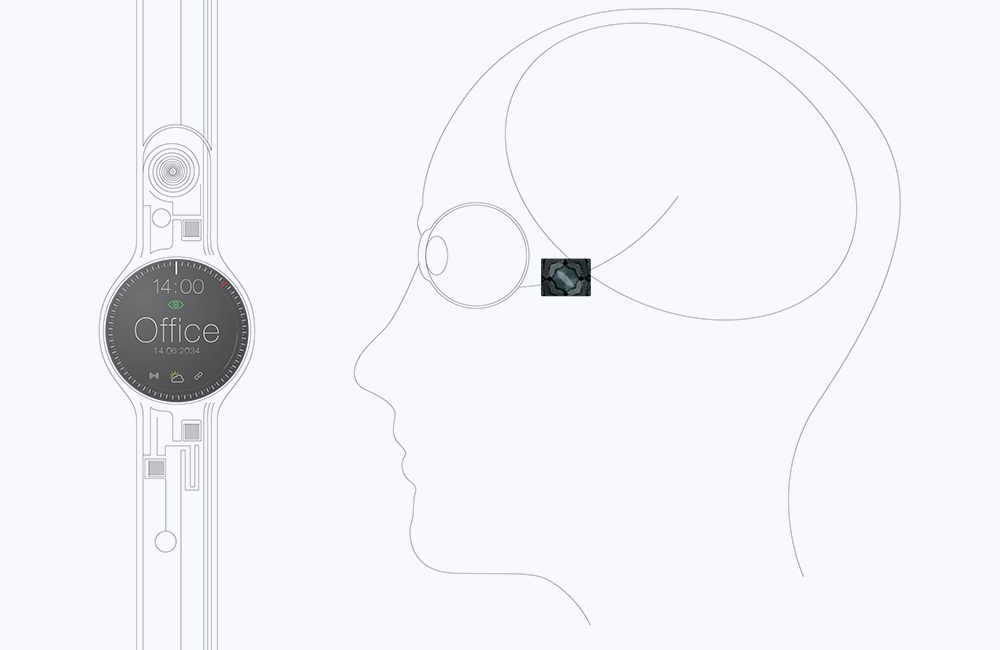

Visuelles Ausgabemedium kann das bedruckte Display des Armbandes sein. Man kann sich aber auch einen Chip auf die Schläfe kleben, über den dann der Informationsaustausch mit dem Auge bzw. dem Gehirn erfolgt (Quelle). Darüber werden dann an allgemein vorgegebenen Standorten (die Werbung wird nerven) Bilder, Informationen oder die Arbeit eingeblendet, ähnlich wie bei einem Headup-Display. Das Ganze kann natürlich „noch“ mechanisch deaktiviert werden.

Wie würde mein Büro also im Jahr 2034 ausgestattet sein? Heute ist auf dem Tisch mein Monitor noch sehr präsent, der in 20 Jahren dort natürlich nicht mehr stehen würde. An seiner Stelle wäre für meine Augen ein virtuelles Display sichtbar, das natürlich über Freigaben an der Stelle, an der ich es sehen würde, auch für andere Personen sichtbar wäre. Sprich: eine körpereigene „Augmented reality“. Die Ausgabe über den Sehnerv kann auch als Eingabe funktionieren, alles was man sieht und mit dem gesehenen interagiert, kann verarbeitet werden.

Wenn ich das auf ein Automotive Beispiel übertrage, könnte das wie folgt aussehen:

Ich greife an die Tür meines Wagens, dieser erkennt mich über meine (nur für zertifizierte Objekte entcodiertbare) Signatur, die von meinem Armband über meinen Körper an meine Hand zum Griff weitergeleitet wird. Ich kann die Tür öffnen und sehe an den gewohnten Stellen die nötigen Informationen, die ich virtuell eingeblendet mit meinen Augen sehen kann. Sollte ein Beifahrer neben mir sitzen, wird er vom System des Wagens erkannt, das zunächst eine Freigabe einfordert. Erst dann kann er über die Ansicht zu den für ihn relevanten Infotainment-Funktionen verfügen. Auf meinem Lenkrad (ja das gibt´s dann immer noch!) sehe ich virtuelle Interaktions-Elemente. Umfangreiche Eingaben wie Suche oder Zieleingaben erfolgen über die Sprechfunktion, die inzwischen wie ein normaler Dialog funktioniert (zehn Jahre später wird über den Sehnerv-Chip eine kognitive Eingabe/Steuerung möglich sein – Quelle).

Über einen Sensor im Armband, der die Körpertemperatur aufnimmt, wird die Klimaanlage gesteuert. Die Musikbibliothek, die in meinem kleinen Finger gespeichert ist, streamt über Funk von Armband zur Headunit und somit zu den Ausgangsmedien die gewünschten Titel.

Aus meinem Daumen ist mein Adressbuch zugänglich und wird an die Navigationssoftware im Armband weitergeleitet.

Das Armband erkennt Gefahrensituationen und kann schneller als das Gehirn reagieren. Es sendet einen Impuls an die Bremsen und das Lenkrad und gewährleistet so viel mehr Sicherheit. Es wird für alle Fahrzeuge einen vordefinierten Abstand geben, der Staus vermeidet und entsprechend vorausschauende Geschwindigkeitsempfehlungen je nach Energieverbrauchswunsch gibt.

Und so weiter und so weiter …